この記事は Rebecca Nathenson (Google Assistant Developer Platform プロダクト ディレクター ) による Google Developers Blog の記事 “New for I/O: Assistant tools and features for Android apps and Smart Displays” を元に翻訳・加筆したものです。詳しくは元記事をご覧ください。

今回の I/O では、Android アプリに Google アシスタントをさらに簡単に導入し、スマート ディスプレイでエンゲージメントを高めるコンテンツを作成するために役立つ、新しいプロダクトを発表しました。

新しい Android API でアシスタント開発が簡単に

App Actions を使うと、Android アプリに Google アシスタントを簡単に導入し、乗りものの予約からソーシャル メディア投稿まで、あらゆるユーザーの要求に応えることができます。MyFitnessPal や Twitter などの企業は、すでに App Actions を使い、声だけでユーザーの要求に応えています。Android Studio では、組み込みインテントをアプリの特定の機能や操作にマッピングすることで、App Actions を有効化できます。以下で紹介するのは、音声クエリや提案によって、ユーザーが簡単にコンテンツを操作できる新しい方法です。

Capabilities でアシスタントの組み込みインテントのサポートを強化

Capabilities は、新しいフレームワーク API で、現在ベータ版として利用できます。これを使うと、組み込みインテントで定義されている共通タスクのサポートが可能となります。インテントのカタログにある組み込みリクエストを活用すると、アプリ内の特定のアクティビティを直接開く方法をユーザーに提供できます。

たとえば、Yahoo Finance アプリでは、Capabilities を使ってユーザーが「OK Google, Yahoo Finance で Verizon の株価を見せて」と言うだけで Verizon の株価ページを直接開けるようになっています。同じように、Snapchat ユーザーも、「OK Google, スニーカーのスナップを送って」と話すだけでフィルタを追加して友達に送ることができます。

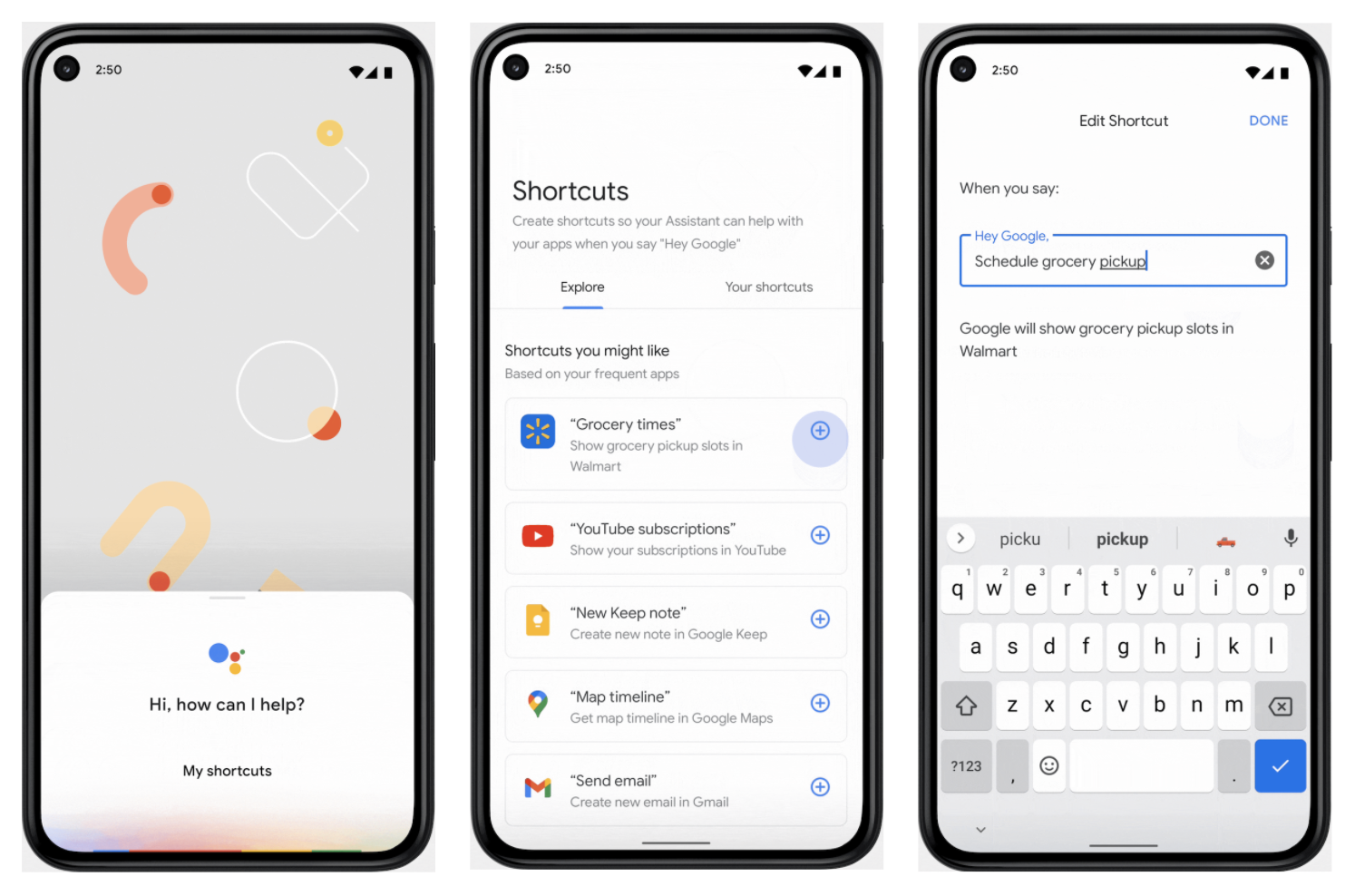

Android 12 のショートカットでアプリを見つけやすく

アプリ ショートカットは、Android で一般的なタスクを自動化する方法として、すでによく使われています。Android 12 の新しいショートカット用 API のおかげで、アプリがサポートしているすべてのアシスタントへの要求が見つけやすくなりました。Android ショートカットを作成すれば、自動的にアシスタント ショートカット ギャラリーに表示されるので、ユーザーは「OK Google、ショートカット」と言うだけで、個人の音声コマンドをアプリに設定できます。

Google アシスタントは皆さんのアプリを使うように促すよう、関連するショートカットも提案できます。たとえば、eBay アプリを使うと、ユーザーの画面に「入札を表示」ショートカットを作成する提案が表示されます。

さらに、Google Shortcuts Integration ライブラリも公開しました。これを使うと、Shortcuts Jetpack モジュールによってプッシュされたショートカットを特定し、関連する音声クエリをアシスタントで管理できるようになります。Google アシスタントが関連するショートカットをユーザーに提案してくれるので、皆さんのアプリを使ってもらえるようになります。

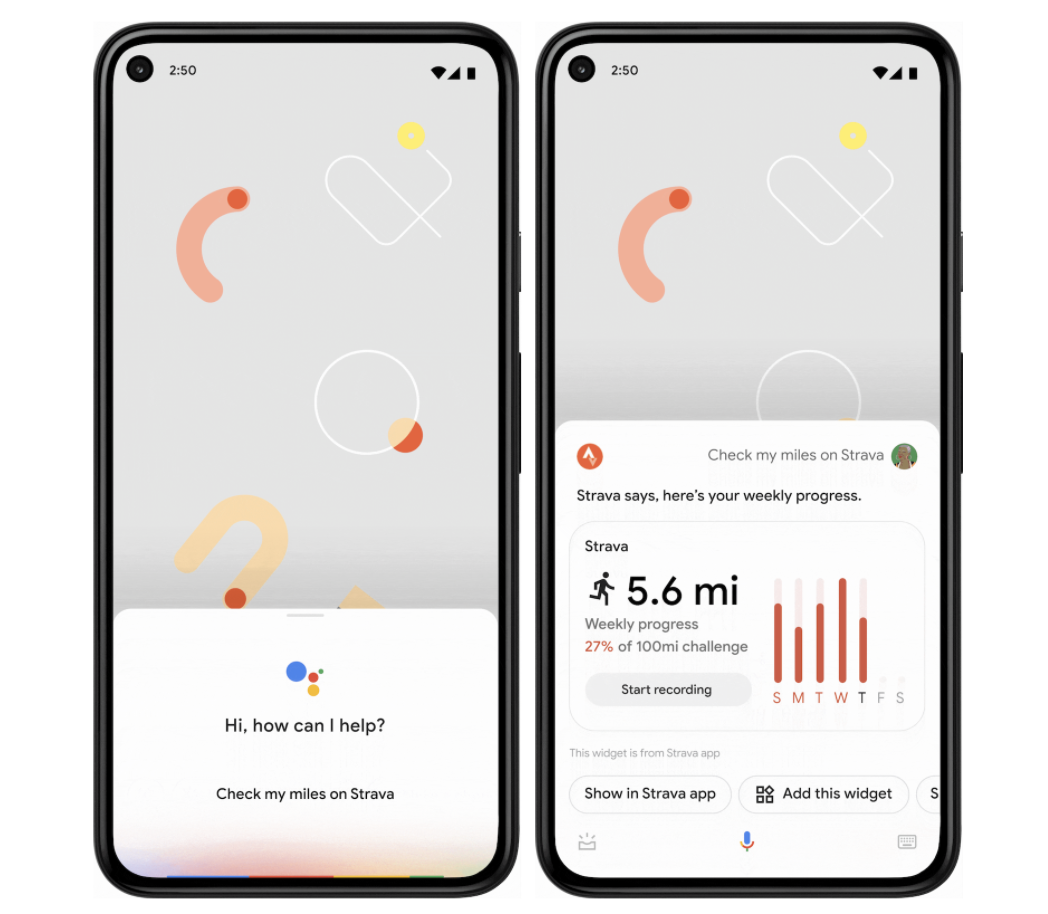

ウィジェットを使ってアシスタントから即座に回答や更新を受け取る(近日公開)

Android 12 の改善により、Capabilities API を使って特定の組み込みインテントをウィジェットにマッピングすることで、ウィジェットでコンテンツをすぐに見つけられるようになります。また、今後は車の運転に最適化されたウィジェットを Android Auto でも簡単に使えるようにする予定です。この方法でアシスタントを組み込むと、同じウィジェットで単発の回答、すばやい更新、複数ステップのインタラクションを実現できます。

たとえば、Dunkin のウィジェット実装では、「OK Google、Dunkin で再注文して」と話しかけると、以前に注文したドリンクを選んで再注文できます。Strava のウィジェットでは、「OK Google、Strava でマイルをチェック」と話しかけると、1 週間の走行距離をトラッキングし、ロック画面に表示できます。

スマート ディスプレイで高品質な会話型アクションを構築する

昨年は、Actions Builder、Actions SDK、そしてデベロッパーとユーザー双方のエクスペリエンスを改善する新しい組み込みインテントなど、スマート ディスプレイ向けのアシスタント プラットフォームに数多くの改善を加えました。ここでお知らせするのは、スマート ディスプレイの会話型アクションをさらに充実させるため、近日中にロールアウトされる改善点です。

デベロッパー エクスペリエンスを改善する新機能

インタラクティブ描画キャンバスは、HTML、CSS、JavaScript などのウェブのテクノロジーを使って、タッチや音声でコントロールするアシスタント用のゲームやストーリーを構築する際に役立ちます。CoolGames、Zynga、GC Turbo などの企業は、すでに描画キャンバスを使ってスマート ディスプレイ用ゲームを構築しています。

この機能をリリースしてから、ウェブコードでコアロジックを実装する方がシンプルで高速だというすばらしいフィードバックをデベロッパーからいただいています。これを実現するため、近日中に Interactive Canvas API からテキスト読み上げ(TTS)、自然言語理解(NLU)、ストレージ API にアクセスできるようにして、デベロッパーがクライアント側コードからこれらの機能をトリガーできるようにします。この API により、経験豊富なウェブ デベロッパーがおなじみの開発フローを利用して、さらに応答性の高い描画キャンバス アクションを作れるようになります。

また、アクションをリリースする選択肢も増やす予定です。近日中に、Actions Console で段階的リリースを管理できるようにします。たとえば、ある国で最初にリリースしてから後でさらに拡大したり、一部のユーザーにだけリリースしてから徐々にロールアウトしたりできるようになります。

スマート ディスプレイでのユーザー エクスペリエンスの改善

スマート ディスプレイで視覚表現を強化する改善も行われています。たとえば、固定ヘッダーを削除してデバイスの全画面を活用することで、ユーザーに臨場感あふれる体験を提供できます。

インタラクティブ描画キャンバスによってスマート ディスプレイでタッチ インターフェースのカスタマイズが可能になる前は、デバイスの画面のどこかをタップして TTS の再生を停止する簡単な方法を提供していました。しかし、スマート ディスプレイでマルチモーダルなエクスペリエンスが増えるにつれて、ユーザーがディスプレイをタップしている間も TTS の再生を継続することが重要になるユースケースが登場しています。そこで、アクションで TTS を継続できるようにするオプションを近日中に提供する予定です。

さらに、Media API を更新して長時間のメディア セッションをサポートしています。これにより、特定の時間から再生を開始する、以前のセッションが停止したところから再開する、メディアの再生状況に応じて会話に応答する、といったことができるようになります。

音声による取引が簡単に

皆様が Google のプラットフォームでビジネスを構築するために必要なツールを用意することがいかに重要であるかは理解しています。昨年 10 月、シームレスな音声ベースとディスプレイベースの収益化機能を簡単に追加できるようにすることをお知らせしました。オンデバイス CVC とクレジット カードの入力が、まもなくスマート ディスプレイで利用できるようになります。この 2 つの機能によって、オンデバイス取引がはるかに簡単になり、ユーザーをモバイル デバイスにリダイレクトする必要がなくなります。

これらの新機能を活用して、モバイルでも自宅でも、エンゲージメントの高い体験を構築し、多くのユーザーに簡単に使っていただけることを期待しています。YouTube の Google I/O でテクニカル セッションやワークショップなどを確認し、早速 App Actions や会話型アクションを始めましょう!

Reviewed by Johan Euphrosine – Developer Relations team